a cura di Cornelio Galas

La fissione nucleare

La scoperta della fissione nucleare risale alla metà degli anni trenta, ed è stata all’origine del Progetto Manhattan e della successiva sfruttabilità militare dell’energia atomica. Nelle armi nucleari a fissione, dette anche “bombe atomiche” (da qui il nome di bomba A, in inglese Abomb) possono essere usati o l’uranio od il plutonio. L’uranio è un elemento chimico della serie degli attinidi, dal numero atomico 92, presente in natura, mentre il plutonio (attinide pure lui), dal numero atomico 94, è un materiale artificiale, derivato dall`arricchimento dell’uranio 238.

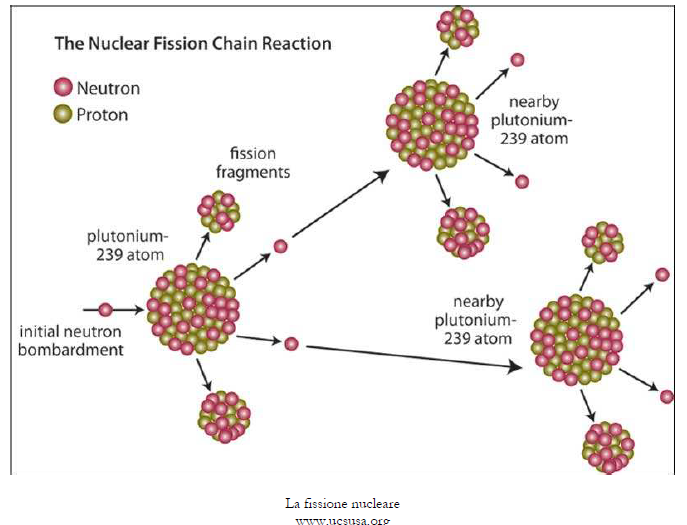

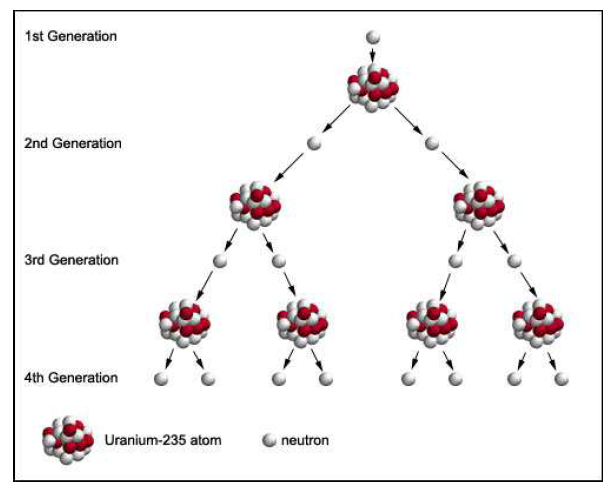

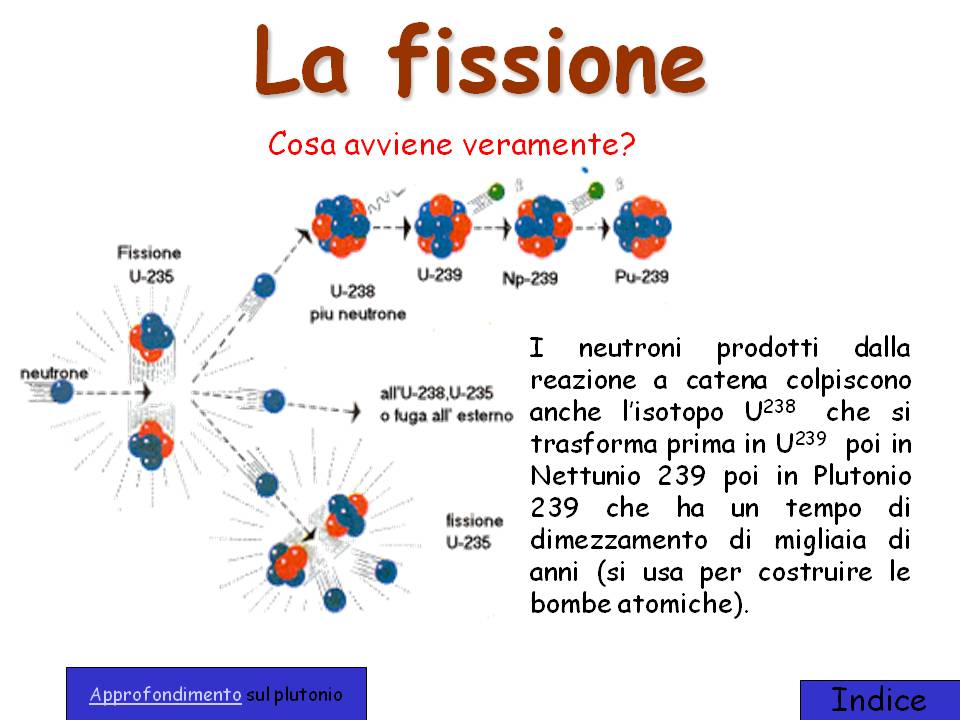

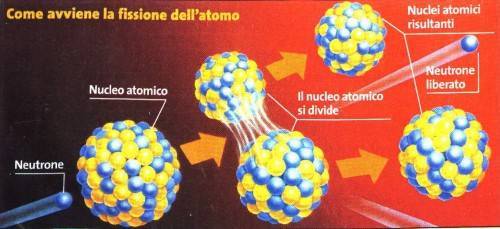

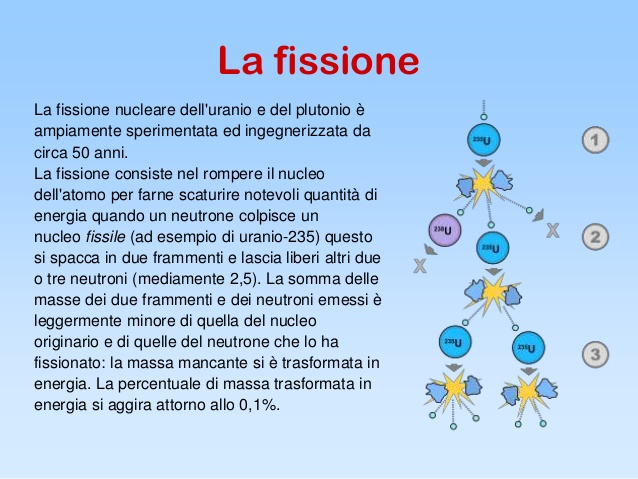

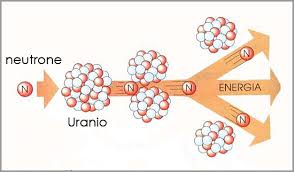

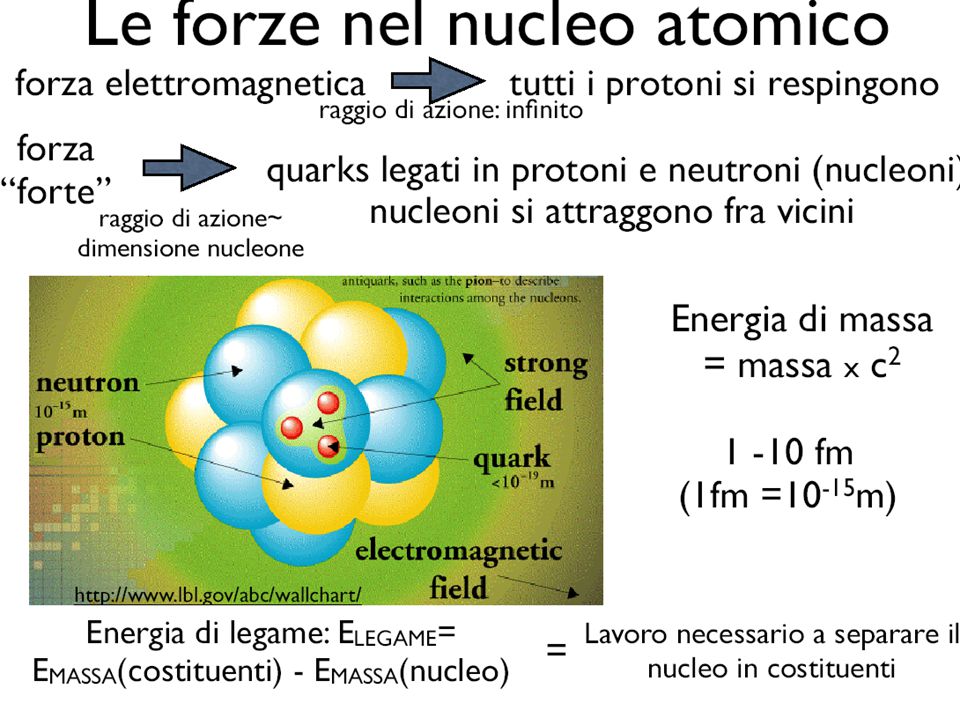

La fissione nucleare avviene quando alcuni neutroni colpiscono una sufficiente quantità, definita “massa critica”, o di plutonio 239 o di uranio 235, secondo la seguente formula:

235U + n → 236U → fission

Tale reazione produce un’instabilità nell’atomo di uranio 235, il quale diviene per brevissimo tempo uranio 236. Per addivenire ad una configurazione più stabile, nell’arco di pochissimi milionesimi di secondo l’atomo di uranio 236 si scinde in due atomi più leggeri, ciascuno dei quali è composto da circa la metà dei protoni e dei neutroni presenti nel nucleo originale. Durante tale fase si libera una grande quantità di energia, raggi gamma e ulteriori neutroni, i quali a loro volta vanno a colpire altri atomi, scindendoli a loro volta.

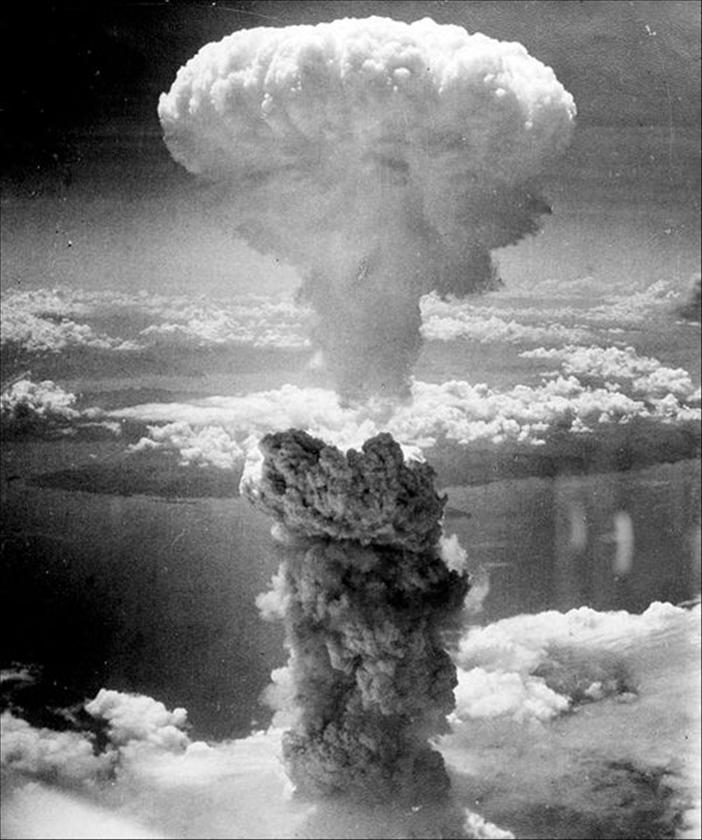

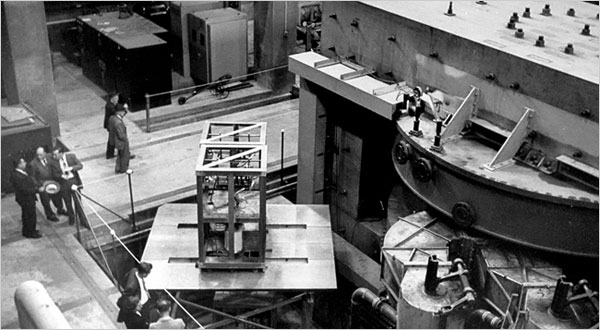

La reazione a catena che ne deriva prosegue a seconda della quantità di materiale fissile presente: se la reazione non è controllata con qualche elemento che sia in grado di assorbire i neutroni (come, ad esempio, la grafite, come scoperto da Fermi) la reazione in pochissimi istanti realizza la fissione nucleare, e cioè lo stesso effetto dei primi ordigni bellici rilasciati su Hiroshima e Nagasaki.

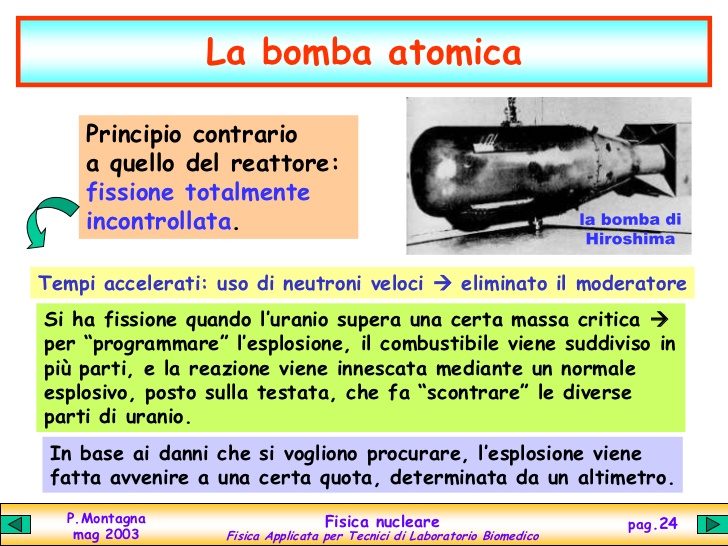

Pertanto, a differenza delle applicazioni civili, nelle bombe atomiche la reazione prosegue incontrollata fino all’esaurimento del materiale fissile. Esistono due differenti modi di innesco di una bomba atomica: il primo consiste nello “sparare” contro un bersaglio di materiale fissile un “proiettile” composto dallo stesso materiale fissile; il secondo, più complesso, si ottiene circondando il materiale fissile di esplosivo convenzionale. Facendo detonare tale esplosivo si comprime il materiale fissile, che di conseguenza esplode. Le due modalità vennero testate già nel corso degli attacchi a Hiroshima e Nagasaki.

La fusione nucleare

La fusione nucleare si muove in direzione esattamente opposta alla fissione. Nel corso del processo di fusione nucleare due elementi leggeri si combinano (si “fondono”, appunto) per creare un elemento più pesante. Tale reazione, che comunque richiede una grande quantità di energia per essere realizzata, è capace di sprigionare un’energia di dimensioni enormi. La fusione nucleare è la tipica forma di energia con la quale si alimenta il sole e, più in generale, ogni stella.

Dopo i primi studi teorici negli anni trenta, gli esperimenti proseguirono per una ventina di anni finchè, verso la fine degli anni quaranta si arrivò verso la vera e propria realizzazione della bomba. Una reazione termonucleare richiede un’enorme quantità di energia per iniziare, e avviene allo stato di plasma (uno stato che naturalmente non esiste sulla terra), cioè in una condizione nella quale gli elettroni si separano dai relativi nuclei.

Come evidente, l’energia per permettere una separazione di questo tipo dev’essere molto notevole: questo è il motivo per cui nelle stelle, dove le temperature sono elevatissime, è normale che la materia si trovi allo stato di plasma, cosa che invece non avviene sulla Terra. Pertanto, con la realizzazione di una temperatura di milioni di gradi è possibile permettere ai singoli nuclei di fondersi insieme, vincendo le ordinarie forze che normalmente li allontanerebbero.

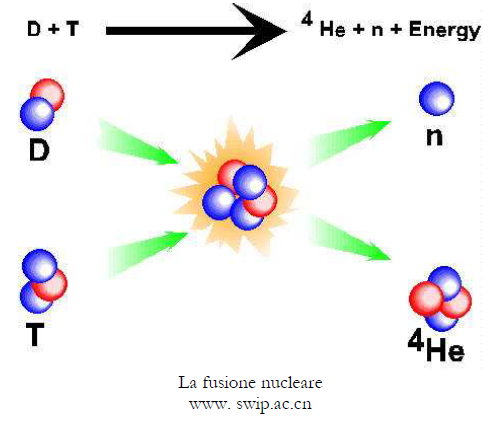

Gli isotopi dell’idrogeno, cioè il deuterio ed il trizio, sono gli elementi ideali per realizzare una fusione nucleare: tale reazione determina la creazione del più pesante atomo di elio, nonché il rilascio di un neutrone, oltre che un’enorme quantità di energia, ed è riassumibile nel seguente modo:

D + T → He + n

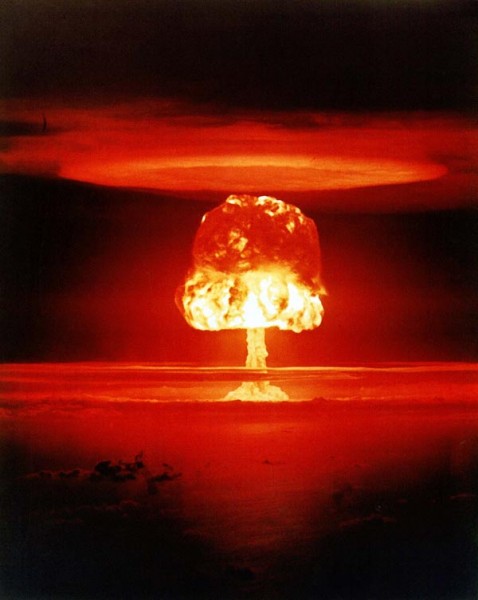

In una bomba termonucleare occorre innanzi tutto generare un’energia sufficiente affinché la fusione abbia inizio, mediante l’esplosione del primary stage, cioè una fissione nucleare, in grado di produrre una temperatura di alcuni milioni di gradi. Tale calore è convogliato verso uno stadio secondario, nel quale si trovano gli elementi destinati a fondersi. Nell’arco di alcune frazioni di secondo si sviluppa la reazione di fusione, la quale genera una fortissima esplosione, una quantità di luce visibile anche a molto chilometri di distanza e capace di accecare, un calore elevatissimo e, naturalmente, il fallout radioattivo.

La resa delle bombe H si misura non in chilotoni come quella delle bombe atomiche, ma in

megatoni.

L’evoluzione dei vettori

Una volta dominata l’energia atomica, per renderla militarmente efficiente occorreva trovare un mezzo idoneo a trasportare l’ordigno presso il luogo dell’esplosione. Inizialmente le armi nucleari erano utilizzabili solo mediante il rilascio da parte di appositi bombardieri, detti strategici: la modalità era analoga a quelle della seconda guerra mondiale. Ma gli sviluppi nucleari probabilmente avrebbero condizionato meno il mondo se non vi fosse stata un analogo sviluppo delle tecnologie di trasporto (i vettori) delle armi stesse. L’evoluzione dei sistemi missilistici è stata, ed è ancora oggi, centrale per gli equilibri geopolitici delle superpotenze, soprattutto in Europa.

Al pari, la nascita di sistemi antimissile si rivelò in grado di alterare il delicato equilibrio che le superpotenze stavano raggiungendo. Da strumenti per andare in orbita i missili furono da subito sfruttati per le loro capacità di trasporto di testate nucleari (e, seppure in minor misura, anche chimiche o addirittura biologiche) su lunghissime distanze, senza più

necessità di ricorrere all’aviazione ed al relativo dominio dello spazio aereo. Comprendere l’evoluzione della missilistica moderna richiede per prima cosa una precisazione terminologica. Se spesso termini come “razzo” e “missile” sono usati in modo intercambiabile, in realtà sono tecnologie che presentano aspetti differenti.

Inoltre la stessa categoria dei missili è soggetta a diverse suddivisioni al suo interno, derivate dallo sviluppo che vi è stato negli ultimi cinquant’anni, e che alla fine ha avuto ripercussioni anche sui ruoli tattici e strategici della missilistica. Pertanto, se in senso lato i due termini sono idonei ad indicare qualsiasi oggetto volante capace di muoversi grazie alla spinta che gli deriva dalla combustione di un propellente, in senso più tecnico i due sistemi presentano notevoli differenze.

Lo studio qui realizzato non si occuperà di sistemi quali il bazooka, i missili anticarro o aria-aria (cioè sparati da aerei contro aerei), ma analizzerà l’impatto della missilistica moderna sulle armi di distruzione di massa, in particolare quelle nucleari. Anche i sistemi sopra citati sfruttano (in scala più ridotta) i medesimi principi che muovono i missili a testata nucleare; stante però le loro dimensioni minute sono in grado di trasportare solo esplosivo convenzionale.

I razzi propriamente detti sono una scoperta molto antica, e per questo di difficile datazione: si ipotizza comunque che siano stati ideati in Cina, e che fossero utilizzati sia per fini ludici (i fuochi artificiali) che militari: sembra comunque chiaro che lo sviluppo dei razzi sia legato a quello della polvere da sparo. Il loro principio di funzionamento si basa sull’espulsione di gas combusti da un ugello presente alla base del razzo: in tale modo esso viene sospinto. Il razzo è un “veicolo o proiettile non guidato che può essere lanciato lungo una traiettoria sfruttando la spinta esercitata da un endoreattore, cioè un motore a reazione che, possedendo al suo interno il combustibile ed il comburente, può prescindere dalla presenza dell’ossigeno per essere attivato”.

Gli studi compiuti nel XIX e nel XX secolo portarono al primo massiccio uso dei razzi militari durante la seconda guerra mondiale: particolare impatto ebbero soprattutto i razzi russi, soprannominati “Katyusha” lanciati in salve da veicoli appositamente attrezzati. Il rumore che emettevano e l’effetto psicologico era violentissimo: il nomignolo che venne dato ai veicoli era “Organo di Stalin”. Questi sistemi, debitamente evoluti, sono in uso ancora oggi, anche se con finalità tattiche.

A fianco degli studi sui razzi, che erano in generale già nel patrimonio culturale di tutte le potenze belligeranti, ben più interessanti si rivelarono gli studi in materia missilistica, nei quali i tedeschi erano nettamente all’avanguardia: come per le tecnologie nucleari, anche quelle missilistiche affondano le loro radici dei delicati anni della seconda guerra mondiale. I missili di oggi rappresentano senza dubbio l’evoluzione degli studi tedeschi: i loro discendenti oggi sono classificabili in moltissimi modi diversi, e hanno applicazioni militari alquanto vaste.

Per ciò che riguarda la possibilità di trasporto di testate nucleari (ma anche convenzionali, chimiche e biologiche) i missili sono detti “strategici”. I missili balistici (in inglese ballistic missiles) si contraddistinguono perchè le fasi “intermedia e finale della traettoria sono soggette alle leggi della balistica”. I missili da crociera (cruise missiles) sono missili “a lungo raggio capaci di trasportare un carico bellico ad armamento convenzionale o nucleare sfruttando caratteristiche aerodinamiche che gli permettono il volo radente sulla superficie del terreno o del mare”.

A loro volta i missili balistici sono divisibili in diversi modi, a seconda della loro zona di lancio (terraferma o mare) e a seconda del loro raggio di azione, secondo la seguente distinzione:

- Missili per uso tattico (sul campo di battaglia);

- Missili di teatro, o medio raggio, detti IRBM (Intermediate-range ballistic missile), con una gittata compresa fra i 160 e i 3.200 chilometri;

- Missili intercontinentali, o ICBM (Intercontinental ballistic missile).

Lo sviluppo delle tecnologie antesignane dei missili fu condotto dai tedeschi, in quanto Hitler prediligeva particolarmente questo tipo di ricerche rispetto a quelle nucleari: “con la creazione di questi missili, la Germania piantò i semi che germogliarono nelle armi di distruzione di massa della guerra fredda”. Dopo la sconfitta subita dalla Luftwaffe durante la “Battaglia d’Inghilterra”, Hitler voleva tornare a terrorizzare i cieli della Gran Bretagna a tutti i costi.

Nel famoso impianto di Peenemunde, in Germania, i tedeschi stavano segretamente testando un nuovo tipo di armi con propulsione a razzo, senza pilota, che potevano caricare una testata di esplosivo convenzionale. I primi esperimenti furono deludenti: i razzi cadevano in direzioni sbagliate o spesso non riuscivano nemmeno a decollare. Questo tipo di esperimenti non passarono inosservati all’intelligence inglese, la quale, grazie ad una serie di informazioni confidenziali raccolte, cominciò ad interessarsi dell’argomento, ed anche a bombardare le installazioni dei razzi per rallentarne lo sviluppo.

Nonostante queste interferenze, al programma missilistico venne data grande priorità, e ciò permise il primo volo della bomba volante V1, Vergeltungswaffen Einz (“arma di rappresaglia numero uno”) nel 1944. Nonostante le diverse incursioni americane ed inglesi, i tedeschi erano riusciti a sperimentare l’antenato dei missili balistici, lanciando le “bombe volanti” verso la Gran Bretagna. I primi attacchi non erano molto positivi, in quanto molti missili caddero in mare, ed altri colpirono obiettivi sbagliati, o a volte precipitarono: tuttavia quando la V1 colpiva, poteva scaricare la sua potenza di ben seicento chili di esplosivo ad alto potenziale.

Le V1 vennero presto seguite dal razzo A4, successivamente noto con il ben più famoso nome di V2: “se la rumorosa e fallimentare V1 è l’antenata dell’odierno missile da crociera, il V2, guidato ed alimentato a carburante liquido è il padre del missile balistico intercontinentale della guerra fredda”.

A capo dei progetti di Peenmunde venne messo un giovane scienziato, Wernher von Braun, il quale dopo la guerra contribuì in maniera decisiva alle missioni spaziali americane “Apollo”. Le V1 e le V2 erano state ideate come armi risolutive della guerra in favore della Germania; non sortirono tale scopo, ma comunque si rivelarono idonee a causare grandi danni, e, soprattutto, attirarono molto l’attenzione degli Alleati. Era scoppiata la “gara per mettere le mani sulla tecnologia missilistica tedesca”.

Russi, inglesi e americani erano intenzionati ad accaparrarsi sia i materiali sia i tecnici che conducevano gli esperimenti; non appena questi venivano trovati, erano immediatamente diretti verso il proprio paese, e ciò era soprattutto valevole per le V2, vere e proprie anticipatrici dell’era spaziale. Dopo la guerra, a Peenmunde vennero effettuate delle prove per vedere come funzionasse la tecnologia tedesca, sfruttando il materiale rimasto. In breve tempo la tecnologia tedesca venne replicata ed implementata, e gli americani erano già in grado di schierare nel 1947 il loro primo missile, il Corporal, capace di essere dotato di una testata convenzionale o nucleare.

A partire dal 1959 potevano essere dispiegati i primi missili IRBM americani, gli Jupiter e i Thor, con un raggio di azione di circa 2500 chilometri e la possibilità di portare una testata nucleare. Anche i russi intanto stavano sviluppando le loro tecnologie, approfittando dei tecnici tedeschi rimasti nella Germania Est. Nei primi anni cinquanta l’Unione Sovietica fu così in grado di schierare i primi missili SS-1, SS-2 ed SS-3 (come indicati dalla Nato), anch’essi capaci di essere caricati con testate nucleari. Tuttavia, almeno fino al 1957, la sfida fra le superpotenze rimaneva ancora vincolata ai bombardieri strategici.

In quell’anno i sovietici lanciarono lo Sputnik, e svilupparono il missile SS-6, il cui raggio d’azione era però corto: doveva essere schierato nei territori russi a nord, e lì incontrava molti problemi dovuti alle rigide condizioni climatiche. Per questo venne deciso di installare a Cuba gli IRBM SS-4, che furono poi la causa della “crisi dei missili” del 1962. Agli SS-4 fecero seguito i modelli SS-5 (capace di testate fino due megatoni) ed SS-6.

I missili cominciavano ad avere gittate di migliaia di chilometri, e su di essi venivano compiuti da entrambe le parti investimenti notevolissimi. Il successivo modello russo SS-7, capace di una testata fino a sei megatoni, fu il primo ICBM che venne utilizzato ad ampio raggio, e venne ritirato nel 1976 dopo gli accordi Start. Gli sviluppi della tecnologia missilistica sovietica preoccupavano molto il Pentagono, che nei primi anni sessanta dovette pure fronteggiare i malumori degli alleati per avere schierato nei loro stati (Italia, Turchia, Gran Bretagna) i propri IRBM.

La soluzione fu lo sviluppo degli ICBM, che potevano essere dispiegati direttamente negli Stati Uniti: nacquero i missili noti come Atlas D e la serie Titan. Stante la capacità di attaccare il suolo nemico direttamente dal proprio stato, entrambe le parti erano vulnerabili agli attacchi, e quindi svilupparono dei missili antimissile detti ABM (anti-ballistic missile), in grado di distruggere i vettori nemici in volo. Nel corso degli anni sessanta vennero poi aumentate le capacità distruttive di ogni missile: invece di caricare una sola testata nucleare ne vennero caricate di più, in modo che il missile potesse portare più testate dirette a colpire obiettivi diversi.

Era la tecnologia MRV, cioè Multiple reentry vehicles, ed aumentava di molto la possibilità di colpire il nemico, in quanto un missile MRV era “dotato di una particolare testata che si apre al momento del rientro in atmosfera lasciando cadere verso terra una serie di veicoli di rientro ai quali non è possibile variare la traiettoria balistica di caduta. Il passaggio successivo consisteva nel riuscire ad “orientare” le singole testate, e condusse negli anni settanta allo sviluppo dei MIRV, cioè Multiple indipendently targetable reentry vehicles.

Questo sistema è una particolare testata “di missile balistico (definita anche testata multipla), costituita da una serie di veicoli di rientro autonomi, ovvero missili autoguidati indipendenti armati con carica nucleare capaci di dirigersi autonomamente verso bersagli diversi al momento del rientro del missile vettore nell’atmosfera”. Gli effetti immediati furono l’aumento a dismisura della potenza di ogni singolo ICBM. Nel 1970 gli americani schierarono il primo MIRV, il Minuteman III, mentre i russi replicarono con i modelli SS-17, SS-18 ed SS-19.

Gli anni ottanta videro poi lo sviluppo di armi quali i missili MIRV (di seconda generazione) Peacekeeper (americani), seguiti dai russi SS-20, poi evolutisi nei modelli SS-24 e SS-25. Parallelamente allo sviluppo dei sistemi lanciati da terra vennero ideati anche missili capaci di essere caricati su sommergibili e da lì lanciabili: era una rivoluzione strategica, considerando che la Terra è composta al 70% circa da acqua. I sommergibili potevano nascondersi ovunque, e ben presto la sfida missilistica prese piede anche in fatto

di SLBM (submarine-launched ballistic missile).

Si cominciò con i russi SS-n-4 e gli americani Polaris della fine degli anni cinquanta fino a giungere ai primi SLBM MIRV come i Poseidon americani e gli SS-n-18 russi, ideati nel corso degli anni settanta. Furono questi i sistemi d’arma più famosi che vennero disciplinati nel corso degli anni settanta e ottanta, e che oggi sono i principali vettori delle armi di distruzione di massa: possono essere caricati con testate nucleari di diverso tipo, forma e intensità, ma comunque sia rimangono i principali mezzi sui quali, anche dopo la guerra fredda, si basano le potenze nucleari mondiali.

Acquisire capacità missilistiche avanzate – e lo dimostrano i recenti casi nordcoreani e iraniani – rappresenta oggi un passaggio essenziale per poter rendere effettiva la propria capacità nucleare. Ed i precedenti casi della Guerra fredda ben fanno capire come oggi si guardi con estremo sospetto ai casi di nazioni che sviluppano tecnologie missilistiche con potenziali caratteristiche dual use, cioè fini sia civili (come l’esplorazione spaziale) che militari (armi strategiche).

Il missile da crociera opera nell’atmosfera, e come tale segue le regole fisiche del volo, come per gli aerei; questo naturalmente richiede combustibile sufficiente dal luogo di partenza fino a quello di arrivo. Anche i missili da crociera sono caricabili con testate nucleari, e pertanto sono stati soggetti ad una forte ricerca da parte delle superpotenze: tuttavia la sfida principale si giocò sulle armi strategiche, le quali concentrarono l’attenzione delle classi politiche al punto addirittura da modificare le dottrine strategiche in materia.

La bomba al neutrone

Una categoria di armi nucleari che è stata particolarmente criticata è la bomba al neutrone, o “Bomba N”, concepita nelle sue linee generali dal fisico Samuel Cohen verso la fine degli anni cinquanta, e che deriva tecnicamente dagli sviluppi della bomba all’idrogeno. Rimuovendo l’uranio da una bomba all’idrogeno, gli scienziati scoprirono che i neutroni potevano aumentare la distanza percorsa, e di conseguenza la loro pericolosità.

La bomba N, conosciuta anche come “enhanced radiation weapon”, nel momento in cui è fatta esplodere, emette un forte scoppio o del fallout, una grande quantità di radiazioni, le quali possono facilmente penetrare esseri umani, armature e strutture interrate. Teoricamente gli effetti di quest’arma colpiscono soprattutto gli esseri viventi, e lasciano intatte le strutture fisiche. Inoltre il livello radioattivo è in grado di decrescere velocemente, in modo che in poco tempo (anche solo alcune ore) le forze convenzionali possano appropriarsi della zona colpita nella quale le infrastrutture sono rimaste virtualmente intatte.

Le bombe N possono essere lanciate dall’artiglieria, da missili o da razzi. L’amministrazione Kennedy decise di iniziare a sviluppare il progetto nei primi anni sessanta: la bomba al neutrone venne pensata per un uso tattico in Europa, soprattutto in Germania, dove si sarebbero concentrate le forze convenzionali del Patto di Varsavia. L’uso di questo tipo di armi sarebbe risultato anche migliore politicamente, in quanto non devastante come le armi nucleari ordinarie.

Il tema era anche dibattuto all’interno della Nato, con le evidenti perplessità della Germania Ovest, la quale avrebbe subito sul proprio suolo l’esplosione delle armi al neutrone. Nonostante il sostegno delle varie amministrazioni americane, quando l’opinione pubblica (e l’Unione Sovietica) vennero a conoscenza della bomba N, essa venne immediatamente bollata come “arma capitalista”, in quanto idonea a distruggere le vite ma non i beni. Le pressioni internazionali e le critiche di alcuni alleati portarono l’amministrazione Carter a sospendere gli studi in materia, ritirando il progetto.

Le ricerche vennero poi riprese dall’amministrazione Reagan, nel 1981, sempre fra molte polemiche, e con la promessa di non farle uscire dal suolo americano se non in caso di guerra. Nonostante la pessima fama internazionale, la bomba al neutrone venne sviluppata e testata dai francesi, i quali poi vi rinunciarono nella metà degli anni ottanta. Nel 1999 la Cina dichiarò di essere riuscita a realizzare la propria bomba al neutrone; l’amministrazione Clinton polemizzò al riguardo, sostenendo che esse erano il risultato dello spionaggio militare cinese a danno dei segreti americani.

Stando all’Encyclopedia of weapons of mass destruction, le bombe al neutrone sono state smantellate nei primi anni novanta. Al momento non si sono mai avute applicazioni belliche della bomba al neutrone, ed anche gli esperimenti noti sono stati pochissimi. Premesso l’interesse cinese (che comunque risale ad una decina di anni fa) non sono noti altri tentativi di sviluppo di armi al neutrone: tale sistema d’arma non risulta nemmeno particolarmente interessante per i gruppi terroristi, per i quali possono produrre danni molto maggiori tecnologie più semplici e meno costose di quelle al neutrone.

Le dottrine di impiego ed i loro effetti

L’uso dell’arma nucleare nel secondo conflitto mondiale fu una decisione strategica presa dal vertice dell’amministrazione americana: in seguito all’ingresso nell’arena militare e politica delle armi nucleari, occorreva ripensare e ripianificare le strategie che stavano alla base delle scelte statunitensi, in quanto il modo di affrontare i conflitti era cambiato per sempre. Tali implicazioni, all’epoca previste solamente dagli Stati Uniti, avrebbero avuto immediate ripercussioni sul sistema militare: a maggior ragione una dottrina di impiego delle armi nucleari si rese indispensabile nel momento in cui le relazioni fra Est ed Ovest cominciarono a raffreddarsi.

L’incapacità inglese di sostenere la resistenza anticomunista in Grecia a causa di difficoltà finanziarie poneva gli Stati Uniti nel dubbio se intervenire sostituendosi al ruolo della Gran Bretagna o permanere nell’isolazionismo. La guerra civile greca fu l’inizio dell’interventismo americano per contenere il comunismo ovunque esso si fosse trovato: in

conseguenza di questo ragionamento106 venne emanata la famosa “dottrina Truman”, la quale fu la prima strategia politica americana del dopoguerra.

L’armamento atomico dell’Unione Sovietica riportò le superpotenze in situazione di parità, almeno fino al lancio americano della prima bomba all’idrogeno; ma la stalinizzazione del blocco orientale, il blocco di Berlino e la guerra di Corea fecero intendere all’amministrazione americana che l’arma atomica non sarebbe stata da sola sufficiente per impedire all’Unione Sovietica il suo comportamento. In altre parole, occorreva ripensare la deterrenza, cioè come scoraggiare l’avversario dal compiere certi tipi di comportamenti militari e politici, ed il solo mostrare le armi nucleari non si era rivelato sufficiente.

La parità militare sovietica cambiò nuovamente la situazione, portando all’elaborazione della dottrina della “rappresaglia massiccia” (in inglese “massive retaliation”) nel gennaio del 1954. John Foster Dulles, Segretario di Stato dell’amministrazione Eisenhower, enunciò la dottrina in un famoso discorso nel quale annunciava che “with massive retaliation, the Usa and its allies threatened an overwhelming nuclear response to any soviet aggression”.

La riflessione di Dulles prendeva le mosse da un documento approvato nell’ottobre del 1953 dal National Security Council, definito NSC-162, il quale ridefiniva le linee di azione in materia nucleare dell’amministrazione, preparando il terreno per il discorso del 1954. Questa strategia, nota anche come “New look” era finalizzata a contenere i costi dello strumento militare convenzionale, affidandosi più alla capacità deterrente esercitata dalle armi nucleari, ed era imperniata appunto sulla massive retaliation, la cui operatività divenne completa nel momento in cui si realizzarono bombardieri strategici capaci di trasportare bombe all’idrogeno.

In seguito agli eventi del 1957 ed alla crescita della paura americana per il “missile gap”, vi furono ripercussioni anche sugli equilibri della deterrenza, alterandoli e portandoli ad assumere nuove geometrie: “the significance of the events of the late 1950s was that the equalization of capabilities brought with it the equalization of vulnerability”. Si era raggiunto l’“equilibrio del terrore”, il che rendeva difficile poter pensare ad una guerra limitata, stando alla potenza degli ordigni disponibili: tutto ciò avrebbe reso ogni conflitto nucleare molto oneroso in termini di vite umane e di distruzioni materiali.

Queste riflessioni si riverberarono nell’adozione di una nuova dottrina, la quale faceva seguito anche al cambiamento di presidenza fra il repubblicano Eisenhower ed il democratico Kennedy. La teoria che venne elaborata dall’allora Segretario alla Difesa Mc Namara fu la teoria della Mutual assured destruction, la cui abbreviazione suonava “MAD”, come il termine “pazzo” in inglese. Tale dottrina si basava sulla possibilità, per entrambe le parti, di possedere una tale capacità distruttiva da rendere i danni inaccettabili per ognuna.

L’equilibrio della MAD risiedeva nella possibilità di una parte di replicare all’attacco dell’altra prima di soccombere: il risultato sarebbe stato perciò indipendente da chi avesse

cominciato, in quanto alla fine entrambi i contendenti avrebbero avuto i relativi territori devastati dalle armi nucleari e dai loro effetti. Per rendere la MAD efficace ci si affidava non solo a strutture nucleari a terra (come i silos) ma anche ai bombardieri strategici ed ai sottomarini dotati di testate nucleari.

Il presupposto della MAD era pertanto la “mutual vulnerability”, cioè la capacità di ciascuna parte di distruggere l’altro: “if either side were able to defend itself against attack, then it might not be deterred against making its own first strike and any stability in the relationship would vanish”. Per questo nel 1972 venne posta una così grande attenzione al tema degli Abm: essi erano in grado di alterare gli equilibri strategici in quanto capaci di neutralizzare la minaccia missilistica.

L’amministrazione Kennedy modificò inoltre la dottrina della rappresaglia massiccia in quella della “risposta flessibile” o flexible response: essa venne proposta da McNamara nel 1962 ed adottata poi dalla Nato nel 1967. L’opzione nucleare della rappresaglia massiccia spaventava l’amministrazione Kennedy: per questo il presidente spinse il sistema militare a presentare più opzioni graduate dalle quali scegliere il comportamento da seguire.

Questo approccio fu all’origine della dottrina della risposta flessibile. In caso di attacco da parte delle forze del Patto di Varsavia, la risposta occidentale sarebbe stata proporzionata al livello di attacco ricevuto, e sarebbe eventualmente “salita di livello” solo nel caso in cui il nemico avesse aumentato l’intensità dell’attacco. In altri termini, in caso di assalto con forze convenzionali, la Nato si sarebbe difesa adoperando forze convenzionali, fintantoché l’avversario non avesse aumentato il livello offensivo, ad esempio usando armi nucleari di teatro. In quel caso, la risposata sarebbe stata proporzionale al nuovo livello raggiunto nell’escalation.

L’effetto che provocò questa dottrina fu la necessità per le forze americane (e della Nato) di aumentare le proprie capacità convenzionali, in quanto se l’attacco fosse rimasto sul piano convenzionale le armi nucleari sarebbero state inutili. Oltre a questo, la risposta flessibile fu alla base del ritiro della Francia dalla Nato (1966), e del suo autonomo perseguimento di una propria politica di potenza basata sulla famosa “force de frappe”, e dotata di armi nucleari.

Con il riaccendersi della Guerra fredda dopo l’attacco sovietico all’Afghanistan, l’amministrazione Reagan si pronunciò a favore della SDI, la “Strategic defence initiative”, nel 1983, un programma di difesa spaziale antimissile il quale, pur non essendo una dottrina, fu in grado di alterare gli equilibri geopolitici del globo, portando infine al collasso dell’Unione Sovietica. Il programma SDI teoricamente prevedeva la possibilità di rendere inefficaci gli attacchi missilistici avversari grazie ad una combinazione si sistemi sia terrestri che spaziali.

Ribattezzata da subito “Guerre Stellari”, la SDI provocò non solo l’innalzamento della tensione con l’Unione Sovietica (che criticò aspramente il progetto) ma anche fra gli alleati della Nato. Con questo sistema, infatti, gli Stati Uniti si garantivano la salvezza da una distruzione nucleare che invece sarebbe stata garantita per gli europei, non coperti dallo “scudo” della SDI.

Nell’arco di pochi anni, però, le ipotesi delle “Guerre Stellari” riuscirono a far implodere l’esausto regime comunista sovietico, incapace di stare al passo con la nuova corsa agli armamenti: in definitiva, quindi, la SDI pur essendo solo uno dei temi che hanno dato origine alla cosiddetta “dottrina Reagan”, hanno comportato effetti molto rilevanti sugli arsenali nucleari mondiali. Il costo estremamente elevato delle tecnologie SDI, possibile per gli Stati Uniti, si scontrava con “l’esaurimento definitivo della residua credibilità del modello di pianificazione sovietica […] Il comunismo si rivelava drammaticamente connesso alle sue genesi strutturali nella penuria e nell’arretratezza”.

L’Unione Sovietica si avviava ad una veloce implosione istituzionale ed economica, accelerata dalle riforme della presidenza Gorbacev. La fine della Guerra fredda comportava, come evidente, una ennesima modificazione delle strategie, nelle quali l’uso delle armi nucleari diminuì, in quanto non più essenziale al mantenimento dell’equilibrio bipolare, sgretolatosi dopo la fine dell’URSS.

La fase di transizione che il mondo si trova a vivere dopo l’11 settembre 2001 ha visto le forze statunitensi e quelle della Nato (al pari di quelle degli altri stati) fronteggiare nemici sub-statali che conducono conflitti di tipo non convenzionale, in cui contano più le capacità di counterinsurgency che le armi nucleari. Rimane comunque aperta la questione dello scudo stellare, il ritiro americano dal trattato anti-ABM e la rinegoziazione del trattato START e NPT.

In questo scenario, le armi nucleari rimangono di certo importanti, ma non sicuramente centrali come lo sono state durante la Guerra Fredda: e questo cambiamento è perfettamente rinvenibile nella National Security Strategy americana del 2008. D’altro canto sarebbe sicuramente utopico e irrealistico considerare che le armi nucleari siano destinate a non pesare più nulla negli assetti geopolitici del mondo contemporaneo.

Le armi biologiche

Il corpo umano, come noto, è vulnerabile non solo alla forza meccanica, ma anche, fra le altre cose, all’azione di determinati virus o microorganismi che in modo impercettibile possono attaccare il corpo, debilitarlo riducendone le possibilità di operare (temporaneamente o permanentemente) e, in certi casi, condurre direttamente alla morte. La presenza e gli effetti dei virus e dei microorganismi patogeni è oggi un dato ben noto, ma solamente grazie agli intensi studi realizzati dalla medicina e dalla biologia negli ultimi secoli.

Le origini di questi studi erano nobili, e puntavano a capire come funzionava l’uomo e gli organismi che gli stavano vicino in modo da debellare malattie che per secoli, come flagelli, avevano afflitto la specie umana. Parallelamente a questo tipo di ricerche non sono però stati risparmiati studi sui modi in cui fosse possibile deliberatamente infettare o attaccare l’uomo con virus o microorganismi: la biologia da strumento di progresso si piegava a divenire ancella della scienza bellica, “public health… in reverse” usando le parole del generale americano William Creasy.

Allo stesso modo in cui si può attaccare un uomo, altre entità patogene sono in grado di attaccare animali e piante; anche questi sistemi erano rudimentalmente noti nell’antichità, per quanto fossero sconosciuti i motivi che potevano portare a questo tipo di decessi. La morte di animali, soprattutto se importanti per il sostentamento umano, la distruzione di coltivazioni e la contaminazione dell’acqua si rivelavano altrettanti elementi idonei per fiaccare le resistenze nemiche e , in definitiva, costringere l’avversario alla resa.

Leggendo le parole di O’Sullivan, si possono scoprire comportamenti secolari e già noti alla storia: “anche i batteri sono stati utilizzati a fini militari per debilitare fisicamente le popolazioni, e facilitare così il loro assoggettamento, o per distruggere piante ed animali ovvero le scorte alimentari”.

Il Dipartimento della Difesa americano definisce arma biologica come “an item of materiel which projects, disperses or disseminates a biological agent including anthropod vectors”. Il recente rifiuto a livello internazionale di utilizzo di armi biologiche (seppure non ancora accettato da tutti gli stati) è avvenuto dopo che per secoli l’uomo ha costantemente usato, a fianco delle armi tradizionali, una serie di accorgimenti per colpire l’avversario con mezzi diversi da quelli messi a disposizione dalla tecnologia militare del momento.

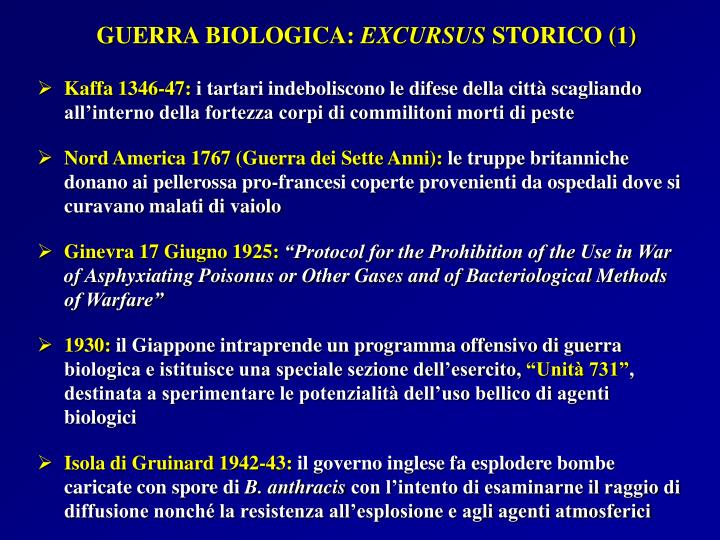

È da sempre ben nota la nocività dei cadaveri: per questo spesso venivano utilizzati per contaminare le falde acquifere del nemico. Allo stesso modo, il primo attacco “biologico” è possibile farlo risalire al 1347, quando nel porto genovese di Caffa (oggi Feodosia, in Ucraina) le truppe tartare scagliarono dentro le mura della città cadaveri di appestati. Secondo diversi storici è da questo evento che prese le mosse la spaventosa diffusione della “Peste nera” nel corso del 1348, ad oggi ricordata come una delle più devastanti epidemie della storia.

L’estrema letalità della Peste Nera è riassumibile con il semplice dato di mortalità della popolazione europea: un terzo degli abitanti dell’epoca morì, e nonostante i tentativi di contenerla, tutto il Vecchio Continente ne venne colpito in momenti diversi. Più recentemente, dopo l’arrivo dei Conquistadores spagnoli nel Nuovo Mondo si cominciarono a diffondere fra la popolazione indigena malattie che in Europa difficilmente potevano avere effetti mortali, ma che invece, traslate in un contesto in cui non si erano mai manifestate, ebbero dei risvolti tragici, causando un consistente numero di decessi.

Gli agenti biologici utilizzati nella realizzazione di questi tipo di armi si dividono in base alla loro tipologia: Virali come il Marburg U, in grado di uccidere un uomo in 72 ore causando una devastante febbre emorragica con un tasso di mortalità intorno al 75% Batteriologici, come la peste. Biologici, come la botolina.

Se questo tipo di contagio non fu intenzionale, ben diverso fu invece il doloso comportamento del governatore inglese della Nuova Scozia, Sir Jeffrey Ahmrest, il quale distribuì alla popolazione indiana alleata dei francesi una serie di coperte infettate dal vaiolo. Era l’anno 1763, e le conseguenze sulla popolazione indiana erano perfettamente prevedibili: il risultato, come voluto, fu una grande serie di decessi.

Analogo caso fu l’infezione di sifilide diffusasi fra le popolazioni maori in Australia a causa di alcune prostitute contagiate: anche qui, l’epilogo era scontato. Questo tipo di attacchi non è stato considerato un sistematico uso dell’arma biologica: i conflitti erano compiuti e

risolti con altri metodi, e questi episodi (o alcuni precedenti, come all’epoca romana o delle guerre del Peloponneso) sono sempre stati marginali ed accessori nello svolgersi delle guerre. Queste azioni erano più il frutto di conoscenze empiriche che di analisi sul fenomeno biologico.

Furono i progressi scientifici della scienza ottocentesca e novecentesca a far compiere alle armi biologiche il vero e proprio “salto di qualità”, man mano che gli scienziati riuscivano a scoprire gli intricati segreti di un mondo microscopico come dimensioni ma enorme come letalità. Per questo un autore come Hutchinson ha, senza giri di parole, definito una “pazzia” l’uso di armi biologiche, sostenendo che “l’utilizzo di batteri, virus e tossine come strumento di guerra li tramuta nella più terrificante fra tutte le armi di distruzione di massa”.

Nonostante l’interesse scientifico per le armi chimiche avesse fortemente catalizzato le attenzioni nel corso dei primi decenni del secolo scorso, le armi biologiche rimanevano comunque nell’agenda di molti governi: erano necessari però ulteriori sviluppi scientifici e tecnologici per permettere lo sfruttamento pieno delle potenzialità belliche della biologia. Con una buona dose di preveggenza, il protocollo di Ginevra del 1925 vietava, alla pari, l’uso (ma non la ricerca e l’accumulazione) di armi “asfissianti, velenose o batteriologiche”.

Se si pensa agli sviluppi di materie come la batteriologia, l’aerobiologia e l’ingegneria genetica, non si possono nascondere delle potenziali ricadute belliche in tutti questi settori. Gli sviluppi storici più recenti delle armi biologiche, ed alcuni incidenti non legati a motivi militari, sono descrizioni chiare di quanto possa essere pericolosa ed insidiosa la minaccia.

Spesso associata alla guerra chimica (tanto da far comparire anche in certa letteratura la definizione di “armi biochimiche” tutte insieme) la guerra biologica se ne differenzia comunque sotto diversi aspetti salienti, primo fra tutti il fattore della trasmissibilità. Mentre gli agenti chimici per quanto possa essere vasta l’area attaccata non potranno allontanarsi più che tanto da essa, o, se si allontaneranno e rimarranno meno concentrati, perderanno la loro letalità (o quantomeno la vedranno diminuita) così non avviene con le armi biologiche.

Un virus che per esempio colpisce una persona, è in grado di attaccarne molte altre con la stessa pericolosità anche se la persona infetta si allontana di molto dalla zona in cui è stata contagiata; inoltre l’incubazione della malattia, che varia a seconda dell’agente patogeno, fa apparire sana una persona che in realtà non lo è, e che quindi contribuisce come un ammalato a diffondere la patologia di cui è portatore.

Pertanto, nonostante le armi chimiche e biologiche presentino sicuramente più affinità fra loro che con le altre armi di distruzione di massa, non si ritiene corretto (ed in questo si è suffragati anche dalle opinioni della maggioranza della letteratura nonché dalla prassi internazionale) riunire le due categorie in un unico insieme.

Le armi biologiche durante la Seconda guerra mondiale

Mentre è alquanto semplice tracciare una chiara evoluzione dello sviluppo dell’arma atomica, non è altrettanto semplice illustrare l’evoluzione delle armi biologiche e del loro impiego. Innanzi tutto i casi storici sono poco rilevanti, in quanto la gran parte dell’evoluzione è avvenuta a partire dall’ottocento. Inoltre la tardiva sfruttabilità militare di questa categoria, ma anche la scarsa – per ora – applicazione bellica che le armi biologiche hanno trovato non ha permesso di creare una consistente casistica.

Le armi biologiche non sono state utilizzate su vasta scala come quelle chimiche né sono state decisive per segnare vere e proprie cesure storiche come quelle nucleari; né, infine, sono state molto presenti (almeno apertamente) nel corso degli equilibri, nelle dottrine e nei trattati della Guerra fredda, e nei conflitti delocalizzati che essa ha generato. Più precisamente in alcuni casi vi sono stati delle “apparizioni” di attacchi biologici, ma essi sono sempre stati indicati come episodi di nicchia o comunque non decisivi.

Ben diverso è invece l’approccio che gli attori non statali hanno avuto con questo tipo di armi: come non ricordare il panico che si diffuse negli Stati Uniti quando, un solo mese dopo il tragico 11 settembre 2001, cominciarono a giungere lettere infettate dall’antrace? La storia militare recente delle armi biologiche stranamente non comincia in Europa, ma in Estremo oriente. La prima unità incaricata di studiare questo tipo di armamento fu la famosa “Unità 731” giapponese, la quale ufficialmente si occupava di potabilizzazione dell’acqua, ma in realtà era una struttura destinata allo studio delle applicazioni belliche degli agenti biologici.

Tale gruppo medico dell’esercito imperiale operava in Cina, in un’area occupata nella quale i giapponesi godevano dell’appoggio di un regime fantoccio ed in cui potevano compiere in tutta tranquillità gli esperimenti nei confronti delle ignare popolazioni cinesi locali. La sede principale dell’Unità 731 si trovava a Ping Fa, e “la struttura includeva 150 edifici, occupando circa 6 chilometri quadrati, con cinque postazioni satellitari ed un totale di tremila scienziati e tecnici giapponesi che vi lavoravano”.

In un’altra area della Cina operava inoltre l’“Unità 100”, un’altra struttura destinata formalmente a occuparsi di sanità equina, ma in realtà destinata a studiare i metodi di diffusione delle armi biologiche con l’artiglieria o con sistemi di aspersione aerea. Nel corso degli anni antecedenti il secondo conflitto mondiale, e poi durante le ostilità, queste unità realizzarono una serie di esperimenti su civili e prigionieri di guerra, così come infezioni su vasta scala mediante aerei e distribuzione di cibo contaminato.

Nei confronti dei detenuti venivano “testate” malattie come la peste, il tifo, la dissenteria o il colera, esponendoli ed infettandoli con i più diversi agenti patogeni. Allo stesso modo vennero colpite ben undici città cinesi con agenti infettivi vaporizzati nell’aria, così come con diffusione di insetti e cibo (grano e riso) contaminato. Infine vi è il sospetto che i giapponesi avessero elaborato anche dei piani, alquanto inverosimili tuttavia, per tentare di infettare il territorio americano con agenti biologici.

Le stime indicano in circa 10.000 prigionieri uccisi nel corso di questi “esperimenti”, e alcuni studi addirittura ipotizzano la cifra di ben 260.000 morti fra i cinesi. Al termine della seconda guerra mondiale tutti gli interrogativi riguardanti le criminose azioni dell’Unità 731 e dell’Unità 100 vennero prontamente “insabbiati” e tutt’ora costituiscono un motivo di discussione non solo storico ma anche politico: molti scienziati giapponesi vennero reclutati per i programmi biologici americani.

Se l’impero del Sole Levante ebbe il triste primato di sfruttare militarmente gli agenti patogeni, non fu di certo il solo che sperimentò tali tecnologie. In Europa il Regno Unito cominciò nel 1940 una serie di esperimenti biologici mirati alla creazione di armi da utilizzare contro la Germania. Per testare il risultato degli studi compiuti, venne requisita la piccola isola di Gruinard, in Scozia, la popolazione venne evacuata e al loro posto vennero trasferiti alcune greggi di pecore sui quali vennero testate le spore di antrace nel corso del 1942 e del 1943. Nell’arco di pochissimo tempo tutte le pecore morirono, e l’isola venne gravemente contaminata dalle spore.

Per lunghi anni gli esperimenti furono coperti dal segreto, e l’isola rimase un’area inaccessibile alla popolazione civile. La decontaminazione definitiva dell’isola avvenne solamente nel 1986, e fu necessaria in quanto, nonostante gli oltre quaranta anni passati, alcune zone risultavano ancora contaminate con delle spore di antrace: alla fine l’isola venne restituita alla popolazione nel 1990.

L’esperimento non solo aveva dimostrato l’estrema letalità dell’antrace, ma anche la capacità delle spore di resistere per lunghissimo tempo; infine aveva dimostrato come i tempi di decontaminazione ed i relativi costi fossero tutt’altro che modesti. Alla fine la Gran Bretagna rinunciò all’opzione biologica contro la Germania, e tutta la vicenda venne posta sotto silenzio fino a pochi anni fa.

Anche gli Stati Uniti si stavano interessando di armi biologiche per un utilizzo nel teatro occidentale; non solo avevano inviato alcuni scienziati a collaborare con i colleghi inglesi, ma stavano cercando di sviluppare un’autonoma capacità sotto il diretto impulso del Segretario di Stato alla Difesa, Henry Stimson, spinti dalla paura, rivelatasi infondata, che i tedeschi fossero in grado di usare armi biologiche.

Nulla invece riguardava la minaccia giapponese, all’epoca non considerata. Gli americani predisposero così alcuni laboratori ed aree di prova in diversi stati, quali Indiana, Utah, Mississippi e Maryland; tuttavia, nonostante gli studi, l’amministrazione americana decise di non utilizzare l’opzione biologica nel corso della guerra.